Performance Analysis of Embedding Cache Models for Optimizing Data Movement in Recommendation Systems

Abstract

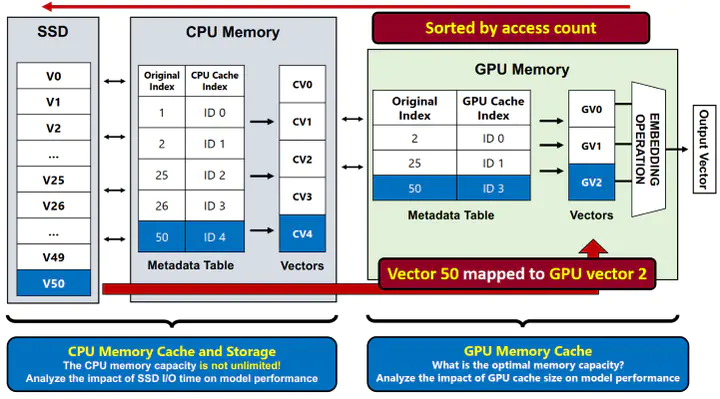

딥러닝 기반 추천 시스템은 심층신경망(DNN) 레이어와 임베딩 레이어로 이루어져 있다. 임베딩 레이어는 범주형 입력값을 이에 대응하는 임베딩 벡터로 변환하는 연산을 수행하며, 임베딩 레이어의 임베딩 테이블 크기는 점진적으로 증가하여 최근에는 수 TB까지 증가하고 있다. 임베딩 레이어는 병렬프로세서를 활용한 성능 가속에 적합한 특성을 가지고 있으나 메모리 용량의 한계가 주요한 병목점이 되고 있다. 이를 해결하기 위한 방법으로 임베딩 테이블 접근 패턴의 지역성을 활용한 임베딩 캐시 모델을 적용할 수 있다. 임베딩 캐시 모델은 GPU, CPU, SSD로 이루어진 계층 구조를 활용하고 있다. 본 연구에서는 임베딩 캐시 모델의 계층별 성능 분석을 진행하였다. 이를 통해 GPU 메모리에 적재되는 임베딩 벡터 캐시 비율 증가가 특정 비율 이상부터는 성능 향상에 미치는 영향이 제한적임을 확인하였다. 또한 이번 연구에서 SSD와 GPU간 데이터 전달이 임베딩 캐시 모델의 주요 성능 병목점이 될 수 있음을 밝혀냈다.

Publication

Korea Computer Congress